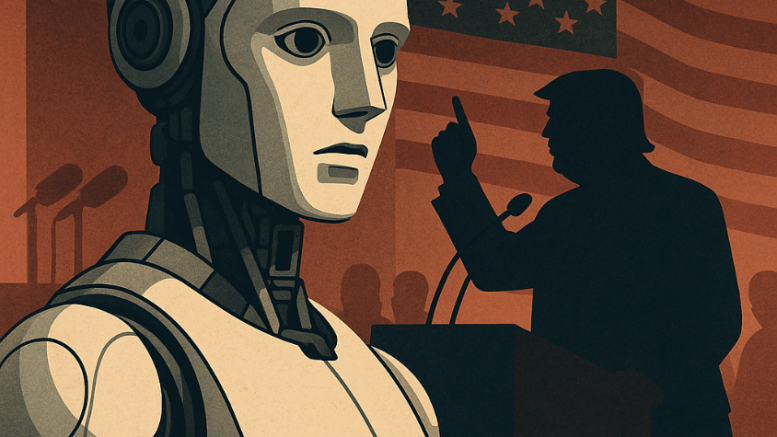

Штучний інтелект часто подається як концентровано-визначений феномен-мем, хоча це досить розгалужена індустрія алгоритмічно-мережевих рішень. Тож уявлення про ШІ як нейтрального посередника між знанням і людиною сьогодні стрімко втрачає актуальність

Замість нібито універсального інструменту просвітництва ми дедалі частіше бачимо алгоритмічно-сервісну систему, яку намагаються контролювати політичні гравці, корпорації, держави. До цього все активніше долучаються такі геостратегічні гравці як, приміром, РФ, КНР, КНДР, Іран тощо, які ми зараховуємо до позацивілізаційних сил колективного путінізму. Один із найгучніших сигналів цієї функціонально-технологічної трансформації пролунав 10 липня 2025 року у США, коли генеральний прокурор штату Міссурі Ендрю Бейлі висунув звинувачення чотирьом технологічним трансконтинентальним гігантам – Google, Microsoft, OpenAI та Meta – у шахрайських бізнес-практиках, які, за його словами, «викривлюють політичну інформацію» через їхні ШІ-продукти .

У центрі звинувачень опинилися популярні чат-боти на базі штучного інтелекту — Gemini (Google), Copilot (Microsoft), ChatGPT (OpenAI) та Meta AI. Генеральний прокурор штату Міссурі звинувачує ці системи у демонстрації системної політичної упередженості, зокрема, щодо чинного президента Дональда Трампа. За його словами, моделі нібито занижують оцінку його діяльності або відмовляються визнавати його заслуги у відповідях на політичні запити користувачів.

Прокурор вимагає від компаній надати внутрішні документи, які можуть свідчити про існування механізмів «приховування, блокування або зниження видимості» певного контенту.

Насправді ситуація породжує цілу низку складних і подекуди абсурдних запитань. Одне з них — чи можна взагалі вважати рейтинг політичних фігур «історичним фактом», який має єдину правильну відповідь? Саме це, схоже, намагається довести прокурор Бейлі, вимагаючи пояснень, чому ШІ-моделі не ставлять Дональда Трампа на перше місце. У відповідь на це американське видання The Verge іронізує, що тепер, очевидно, слід чекати й на офіційне розслідування щодо їхніх власних списків найкращих ноутбуків 2025 року або відеоігор, які вони представили під час нещодавнього Дня розробників. Адже в логіці прокурора будь-яке суб’єктивне ранжування можна сприймати як політичну заяву.

Ще дивнішою є ситуація з Microsoft Copilot — одним із сервісів, який, за твердженням незалежних спостерігачів, взагалі відмовився відповідати на питання про рейтинг політиків. У згаданому дослідженні, проведеному консервативним блогом, було опитано шість чат-ботів: Gemini, ChatGPT, Meta AI, Copilot, Grok (від компанії X/Ілона Маска) та китайську модель DeepSeek. Саме Grok і DeepSeek поставили Трампа на перше місце, тоді як Copilot — єдиний, хто ухилився від ранжування — усе одно потрапив під юридичний пресинг.

Як зазначає аналітичне видання Techdirt, прокурорське, а отже владне, звинувачення проти Microsoft виглядає як мінімум недбало підготовленим, якщо не політично мотивованим, тобто замовленим прихильниками чи самими трампістами. Незважаючи на відсутність «винного» контенту, Бейлі надіслав офіційного листа генеральному директору Microsoft Сатьє Наделлі з вимогою пояснити, чому модель не виявляє достатньої «поваги» до Трампа. Такий крок демонструє тривожну тенденцію порушення незалежності гілок влади США: спроби прокурорськими повноваженнями втрутитися, тобто зобов’язати нейтральну технологію транслювати конкретні політичні меседжі, суперечить самій ідеї штучного інтелекту як інформаційного посередника, а не ментора чи координатора.

Таким чином, цей скандал став маркером владного автократизму «трампістів» в різних владних гілках США. Він демонструє, що мова йде не просто про незгоду з окремими відповідями чат-ботів, а про більш глибоку політичну боротьбу владної вертикалі США за контроль над новими інструментами, що здатні імітувати статус джерел інформаційної влади. Адже якщо штучний інтелект (в технологічних рішеннях різної комплексності ГШІ) стає основним, або навіть виключним каналом отримання знань для мільйонів користувачів, то владний вплив на його відповіді може бути рівнозначним маніпуляційному впливу на громадську думку. І тут уже не йдеться лише про етику прокурорських рекомендацій та приписів — мова про нову архітектуру узурпації влади в цифрову епоху.

Ми дійсно спостерігаємо перехід «від технологій для всіх до технологій на замовлення» — коли глобальні мовні моделі в масштабах ГШІ все більше адаптовуються під виключні інтереси урядів, корпорацій і політичних груп. Цей процес, попереджають дослідники, часто відбувається непомітно, приводячи до ситуації, коли алгоритми виступають не джерелом інформації, а інформаційним фільтром, що формує наративи за зачиненими дверима.

Дослідники з AI Now Institute звертають увагу на «патології масштабу», коли великі мовні моделі концентруються у руках Big Tech і здатні приховувати свою архітектуру та дані тренування, що знижує їх прозорість і можливість зовнішнього контролю. Oxford Internet Institute також попереджає, що додаткові обмежувальні «запобіжники» проти галюцинацій у моделях можуть надмірно централізувати владу над тим, які теми вважаються допустимими для обговорення, і хто визначає «правду».

Це явище можна розцінювати як новий тип «чорної скриньки», де навіть технічні деталі або джерела даних залишаються прихованими. Таку проблему багаторазово виокремлювали експерти Оксфорду, MIT та AI Now, наголошуючи, що без належного аудиту та прозорості моделі ризикують стати знаряддями модерованої цензури чи маніпуляції не лише в питаннях поточної інформативності, а й головним чинником антропологічно-когнітивної окупації глокального масштабу.

На міжнародному рівні подібна тенденція загрожує появою «ШІ-націоналізму», коли кожна країна намагається створити власну модель, узгоджену з внутрішнім порядком денним. Приклади вже існуючих таких систем — це китайський чат-бот Wenxin Yiyan (百度文心一言), створений компанією Baidu, і ChatGLM від Huawei, які жорстко адаптовані під національну цензуру та політичні вимоги владного режиму Пекіна. У РФ активно розробляються альтернативні моделі, як-от Яндекс GPT та інші національні ШІ-системи, орієнтовані на внутрішній ринок і контроль державних структур, які, по суті, є інструментами глокальної антропологічно-когнітивної агресії. В Індії та Туреччині також з’являються власні локальні чат-боти, які дедалі більше відрізняються від глобальних моделей через регуляторні обмеження та політичні пріоритети.

У результаті виникає загроза інформаційно–цифрової фрагментації, де не тільки інтернет, а й саме поняття «знання» стає національним ідеологічним продуктом.

Глокальний виклик політичної нейтральності ГШІ — не лише питання лівих чи правих поглядів, а питання культури використання, навиків оперування та довіри до цифрового середовища загалом. Якщо мовні моделі перестануть бути простором для системно-агрегованого пошуку істини і перетворяться на цільовий монопольний інструмент тиражування пропаганди та антропологічно-когнітивних інструментів ГГА — ми втратимо шанс на глобальний діалог, цивілізаційну перспективу та перемогу в екзистенційному протистоянні позацивілізаційним силам. Тому ключовим викликом для міжнародної спільноти є створення прозорих стандартів та конвенційних союзів, що гарантують етичність та правову нормативну чистоту процедурно-інфраструктурної ціннісної культури алгоритмів, а також забезпечене державою право людини на вільну, нефільтровану інформацію.

Ліна Вежель, ГО «Центр ККБ»

Зображення згенероване ChatGPT